Kể từ khi thành lập, Apple luôn ưu tiên quyền riêng tư và bảo mật. Nó không hài lòng với việc sản xuất smartphone và máy tính bảng tốt nhất, bán chạy nhất mà còn mong muốn khách hàng của mình cảm thấy thoải mái khi sử dụng thiết bị của họ. Với iOS 15, Apple đang mang đến một lớp bảo mật khác cho thiết bị của họ, nhờ vào ‘Child Safety’.

Hôm nay, chúng tôi sẽ cho bạn biết khá nhiều điều bạn cần biết về Child Safety và giúp bạn hiểu cách Apple đưa hệ thống lọc này vào hoạt động. Bây giờ, không cần phải giải thích gì thêm, hãy cùng chúng tôi tìm hiểu An toàn cho trẻ em là gì và nó có thể tác động như thế nào đến cuộc sống hàng ngày của bạn.

Xem nhanh

Child Safety có nghĩa là gì trong iOS 15?

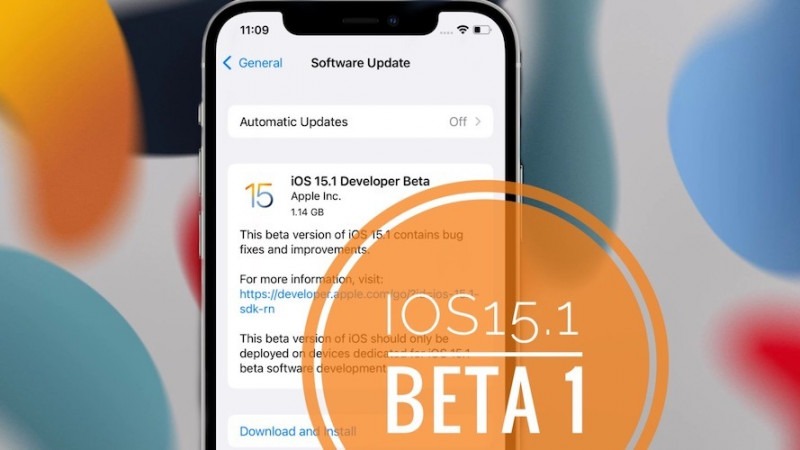

Child Safety là một tính năng của iOS 15 nhằm hạn chế việc phát tán Tài liệu lạm dụng tình dục trẻ em (CSAM) và giúp bảo vệ trẻ em khỏi những kẻ săn mồi sử dụng các công cụ liên lạc để khai thác chúng. Apple sẽ triển khai tính năng này trước tiên ở Hoa Kỳ và sau đó các khu vực khác sẽ làm theo. Đó là một tính năng gấp ba lần có khả năng khiến tâm trí của các bậc cha mẹ được thoải mái. Như mọi khi, bổ sung mới này đang được triển khai miễn phí. Điều kiện tiên quyết duy nhất là iOS 15 .

Apple đang hợp tác chặt chẽ với các chuyên gia hàng đầu về an toàn trẻ em để làm cho hệ thống này càng chống lại sự đánh lừa càng tốt.

Apple triển khai An toàn cho trẻ em trong iOS 15 như thế nào?

Bộ tính năng An toàn cho Trẻ em không được xây dựng trong một sớm một chiều; Apple đã hoàn thiện nó qua nhiều lần lặp lại. Ở dạng hiện tại, An toàn cho trẻ em trong iOS 15 được chia thành ba phần. Phần đầu tiên là an toàn giao tiếp trong ứng dụng Tin nhắn mặc định. Cái thứ hai là quét CSAM trong Ảnh iCloud. Và cuối cùng, phần thứ ba là hướng dẫn an toàn hơn trong Siri và tìm kiếm. Dưới đây, chúng ta sẽ tìm hiểu những điều này có nghĩa là gì.

An toàn giao tiếp trong ứng dụng Tin nhắn

Ứng dụng Tin nhắn mặc định trong iOS được cho là một trong những phần hấp dẫn nhất của thiết bị Apple, đó là lý do tại sao hệ thống lọc này có tiềm năng đặc biệt hiệu quả. An toàn giao tiếp thêm một lớp bổ sung vào giao diện người dùng Tin nhắn của con bạn. Khi họ nhận được một hình ảnh khiêu dâm, bức ảnh sẽ bị mờ và họ được cho biết tính chất nhạy cảm của bức ảnh. Nếu họ vẫn muốn tiếp tục, có một điều khoản để gửi cảnh báo cho cha mẹ hoặc người giám hộ. Hệ thống lọc tương tự cũng hoạt động nếu trẻ vị thành niên chọn gửi ảnh khiêu dâm. Các bậc cha mẹ sẽ được cảnh báo nếu con họ chọn bỏ qua cảnh báo và nhấn gửi.

Tính năng này dành riêng cho các tài khoản được thiết lập dưới dạng gia đình trong iCloud trong iOS 15, iPadOS 15 và macOS Monterey.

Phát hiện CSAM trong Ảnh iCloud

Phát hiện CSAM trong Ảnh iCloud là cách triển khai rộng rãi nhất của chương trình An toàn cho Trẻ em. Nó ảnh hưởng đến mọi người dùng sao lưu ảnh của họ lên iCloud, điều này đã gây ra một chút ồn ào trên các phương tiện truyền thông gần đây. Để phát hiện và ngăn chặn việc phát tán Tài liệu Lạm dụng Tình dục Trẻ em (CSAM), Apple đang sử dụng các kỹ thuật mật mã tiên tiến. Sau khi một hình ảnh được phát hiện và được chứng minh là vi phạm các nguyên tắc, các thiết bị iOS 15 và iPadOS 15 sẽ báo cáo các trường hợp đó cho Trung tâm Quốc gia về Trẻ em mất tích và Bị bóc lột (NCMEC). NCMEC là trung tâm của tất cả các báo cáo do CSAM hậu thuẫn và hợp tác chặt chẽ với các văn phòng thực thi pháp luật trên khắp Hoa Kỳ để trừng phạt những kẻ vi phạm.

Việc “quét” ảnh có thể gây ra một số dấu hiệu đỏ, nhưng Apple đảm bảo rằng họ không quét tất cả ảnh trên iCloud. Nó chỉ quét những bức ảnh phù hợp với một hồ sơ nhất định. Hồ sơ được cung cấp bởi NCMEC và các dịch vụ an toàn cho trẻ em khác. Học máy trên thiết bị đóng một vai trò quan trọng trong việc phát hiện CSAM. Nó giới hạn độ phơi sáng và phân tích chính xác các bức ảnh nhạy cảm để tạo sự yên tâm cho các bậc phụ huynh.

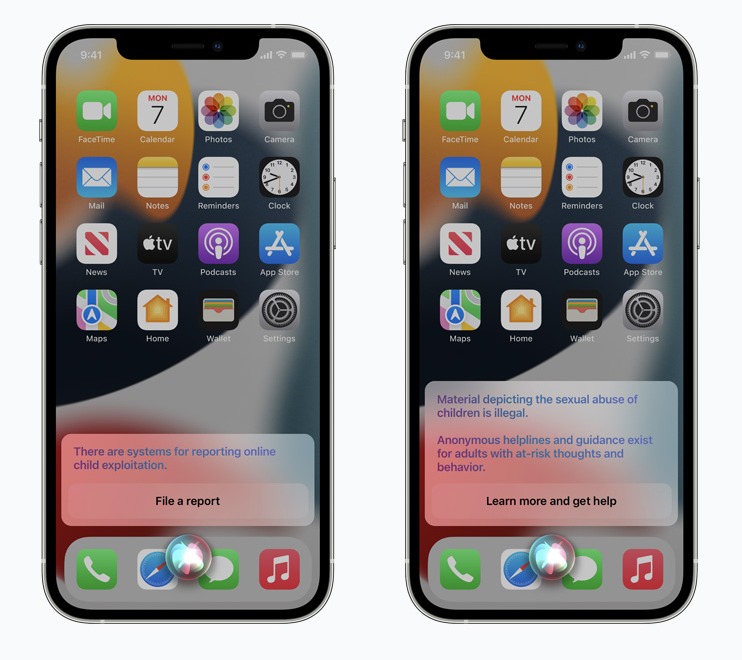

Hướng dẫn an toàn hơn trong Siri và Tìm kiếm

Trong khi tính năng phát hiện CSAM trong iCloud và An toàn giao tiếp tập trung vào việc bảo vệ trẻ em dưới tuổi bị phơi nhiễm. Hướng dẫn an toàn hơn trong Siri và Tìm kiếm đang dạy người dùng về hành vi có vấn đề. Nếu người dùng sử dụng tính năng tìm kiếm bằng giọng nói Siri hoặc Tìm kiếm thông thường để tìm kiếm các truy vấn liên quan đến Tài liệu lạm dụng tình dục trẻ em, thì iOS 15 sẽ can thiệp bằng một thông báo cảnh báo. Cảnh báo giải thích rằng việc quan tâm đến những chủ đề như vậy là có vấn đề và có hại. iOS 15 thậm chí còn cung cấp tài nguyên để giúp ai đó giải quyết vấn đề.

Bạn có thể tắt An toàn cho Trẻ em không?

Tính năng An toàn cho Trẻ em vốn đã được tích hợp sẵn trong iOS 15. Vì vậy, bạn không thể từ chối nó cho tốt. Tuy nhiên, có một số điều kiện mà bạn phải đáp ứng để giữ cho dịch vụ hoạt động như dự kiến. Đầu tiên, tính năng ‘An toàn giao tiếp’ chỉ dành riêng cho các tài khoản được thiết lập là ‘Gia đình’. Các tài khoản biệt lập không có tính năng này. Ngoài ra, hiện tại, tính năng phát hiện CSAM chỉ phát huy tác dụng trong ảnh iCloud. Nếu bạn không có iCloud, iOS 15 sẽ không quét thư viện riêng tư của bạn để tìm CSAM.

Không có chuyển đổi riêng biệt để tắt dịch vụ, chỉ có các cách gián tiếp để tắt nó.

Các câu hỏi thường gặp

Mọi người có thể truy cập An toàn giao tiếp trong Tin nhắn không?

Không, chủ tài khoản tiêu chuẩn không thể truy cập an toàn thông tin liên lạc. Tài khoản của bạn bắt buộc phải được thiết lập là ‘Gia đình’ trong cài đặt iCloud trước khi bạn có thể làm cho tính năng An toàn cho trẻ em hoạt động trong iOS 15.

Các biện pháp An toàn cho Trẻ em mới có làm gián đoạn quyền riêng tư không?

Apple đã phải đối mặt với rất nhiều rắc rối liên quan đến thông báo quét ảnh. Tuy nhiên, công ty đảm bảo rằng họ không có ý định quét tất cả ảnh của bạn và sẽ không có quyền truy cập vào bất kỳ ảnh hoặc tin nhắn nào của bạn. Nó sẽ chỉ đơn giản là kiểm tra chéo ảnh và tin nhắn của bạn với các hồ sơ CSAM đã biết và báo cáo cho chính quyền nếu cần.

Liệu Apple có quét tất cả ảnh trên iPhone của bạn không?

Không có Apple sẽ không quét tất cả ảnh của bạn trong iPhone chạy iOS 15 của bạn. Nó sẽ sử dụng máy học trên thiết bị để tham chiếu chéo các ảnh bạn đang tải lên iCloud, lưu ý các mục CSAM bị nghi ngờ. Nếu bạn không tải ảnh lên iCloud, dịch vụ CSAM sẽ bị tắt theo mặc định.

Tính năng phát hiện CSAM có áp dụng cho ảnh cũ hay chỉ ảnh mới không?

Tính năng phát hiện CSAM áp dụng cho cả ảnh cũ và ảnh mới. Nếu ai đó có các tập tin truyền thông ám chỉ lạm dụng tình dục trẻ em, CSAM sẽ thông báo cho các cơ quan chức năng ngay lập tức và các hành động thích hợp sẽ được thực hiện.

Những bức ảnh vô tội bị CSAM xử lý như thế nào?

Tính năng phát hiện CSAM cho ảnh trong iCloud hoạt động bằng cách kiểm tra chéo ảnh với các ảnh CSAM đã biết. Nếu không có kết quả phù hợp nào được xác định thì ảnh sẽ được bật đèn xanh. Vì vậy, nếu bạn lo lắng về việc Apple báo cáo hình ảnh khỏa thân / bán khỏa thân của con bạn trên smartphone của bạn, hãy yên tâm rằng công ty đang làm việc với nhiều tổ chức để đảm bảo không có báo cáo sai nào được đăng ký.

Chính phủ sẽ sử dụng tính năng quét trên thiết bị của Apple?

Apple luôn là người ủng hộ mạnh mẽ quyền riêng tư, đến nỗi nó tự hào là công ty tư nhân nhất hiện có. Vì vậy, khi Apple đưa ra tính năng quét trên thiết bị, báo thức bắt đầu kêu. Tuy nhiên, Apple đã đảm bảo rằng hệ thống An toàn Trẻ em sẽ không được sử dụng bởi chính phủ hoặc bất kỳ bên nào khác để quét các file cá nhân của người dùng. Toàn bộ hệ thống hoàn toàn có thể kiểm tra được và có nhiều két bảo mật để bảo vệ dữ liệu người dùng.

![[Cảnh báo] Ứng dụng bảo mật Android hàng nghìn lượt cài đặt là phần mềm độc hại (Malware)](https://bigtop.vn/blog/wp-content/uploads/2022/01/android-toxic.jpg)